Você já viu os vídeos: uma Taylor Swift perfeita demais promovendo utensílios de cozinha gratuitos. Um falso Tom Hanks oferecendo seguro odontológico.

Eles parecem reais, mas não são.

Nova pesquisa do McAfee Labs mostra como esses golpes se tornaram comuns.

Nossa Lista das celebridades mais perigosas: lista de Deepfakes de 2025 classifica as celebridades e influenciadores cujas imagens são mais utilizadas indevidamente por golpistas e revela um mercado crescente de recomendações falsas geradas por inteligência artificial.

No topo da lista? Taylor Swift, seguida por Scarlett Johansson, Jenna Ortega e Sydney Sweeney. Globalmente, nomes como Brad Pitt, Billie Eilish e Emma Watson também aparecem entre os mais explorados.

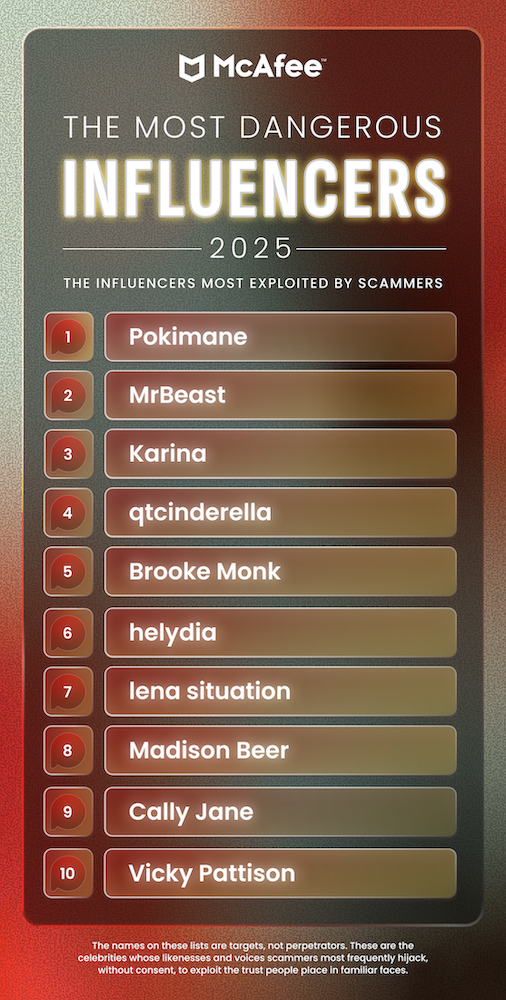

A McAfee também divulgou sua primeira lista de deepfakes de influenciadores, liderada pela gamer e streamer Pokimane, mostrando que os golpistas agora estão visando as plataformas sociais de forma tão agressiva quanto visam as celebridades de Hollywood.

As 10 celebridades mais perigosas (2025): EUA

.

As 10 celebridades mais perigosas (2025): Global

.

Os 10 influenciadores mais perigosos (2025): Global

Por que os golpistas adoram rostos famosos

A fórmula é simples: usar alguém em quem as pessoas confiam para vender algo que não existe.

Criminosos clonam vozes e rostos de celebridades com IA para promover sorteios falsos, produtos de cuidados com a pele, investimentos em criptomoedas ou ofertas “exclusivas” que levam diretamente a malware ou fraudes de pagamento.

De acordo com a pesquisa da McAfee com 8.600 pessoas em todo o mundo:

- 72% dos americanos já viram recomendações falsas de celebridades ou influenciadores.

- 39% já clicaram em uma recomendação falsa.

- 1 em cada 10 perdeu dinheiro ou dados pessoais, com uma média de US$ 525 por vítima.

Os golpistas exploram a confiança. Quando você vê um rosto conhecido, seu cérebro automaticamente baixa a guarda. E é exatamente com isso que eles contam.

Como os deepfakes estão aparecendo cada vez mais nas manchetes

A IA fez com que esses golpes parecessem assustadoramente reais.

Geradores de deepfake modernos conseguem imitar vozes, movimentos faciais e até microexpressões com uma precisão impressionante. Apenas 29% das pessoas se sentem confiantes em identificar uma falsificação, e 21% admitem ter insegurança em identificar deepfakes.

Foi assim que as recomendações falsas e os golpes de romance com IA explodiram na Internet.

- Uma mulher na França perdeu quase US$ 900.000 para um golpista que se fez passar por Brad Pitt, com imagens e mensagens de voz geradas por IA.

- O apresentador de TV Al Roker foi recentemente alvo de um vídeo deepfake falso dizendo que ele havia sofrido ataques cardíacos.

- Tom Hanks, Oprah e Scarlett Johansson também já apareceram em anúncios fraudulentos de produtos com os quais nunca tiveram nenhuma relação.

A frase “ver para crer” já não vale mais — e os golpistas sabem disso.

A psicologia do golpe

Golpes com deepfakes não dependem só da tecnologia; eles se aproveitam das relações parassociais, aqueles vínculos emocionais de mão única que fãs criam com figuras públicas.

Quando uma “celebridade” te manda mensagem, nem sempre soa estranho. Parece pessoal. Essa sensação de intimidade faz as pessoas agirem antes de pensar.

É a mesma estratégia psicológica por trás dos golpes românticos, agora potencializada por ferramentas de IA que fazem com que vídeos e mensagens de voz falsos soem assustadoramente reais.

Como você pode se proteger

- Pense antes de clicar. Se um anúncio ou post parecer estranho ou “bom demais para ser verdade”, provavelmente é.

- Verifique na fonte. Confira o perfil verificado da celebridade nas redes sociais. Os golpistas geralmente copiam fotos de perfil e a bio, mas deixam passar detalhes sutis, como estilo de postagem ou padrões de engajamento.

- Procure sinais de manipulação de IA. Fique atento a movimentos labiais fora de sincronia, tom de voz robótico ou iluminação estranha.

- Nunca compartilhe dados pessoais ou de pagamento por meio de mensagens, mesmo que o remetente pareça ser verificado.

Principais conclusões

O estilo de vida das celebridades e influenciadores sempre direcionou o que compramos, mas agora está mudando a forma como os golpistas nos enganam. Esses deepfake não apenas roubam dinheiro, mas também minam nossa confiança no que vemos, ouvimos e compartilhamos online.

As celebridades no centro desses golpes não são cúmplices, elas também são vítimas, pois os criminosos se apropriam de suas imagens para explorar o vínculo entre os fãs e as pessoas que eles admiram. E à medida que as ferramentas de deepfake se tornam mais fáceis de usar, a linha entre o real e o falso está desaparecendo rapidamente.

O próximo “sorteio” viral pode nem ser um anúncio de verdade… pode ser apenas uma armadilha.

Você não pode impedir que os golpistas clonem rostos famosos, mas pode impedir que eles te enganem.